Jakiś czas temu w tekście pt. Tworzymy człowieka, czyli fałszywa tożsamość wspominałem o możliwościach sztucznej inteligencji i technologii deepfake, którą można wykorzystać do wygenerowania realistycznie wyglądającego nagrania wideo dowolnej osoby. Postanowiłem wrócić do tego tematu ponieważ znalazłem ostatnio trochę czasu by samemu pobawić się tego typu algorytmami.

Z pomocą przyszło mi tutaj środowisko Google Colaboratory i udostępniony w nim gotowy przepis na wykorzystanie projektu First Order Motion Model z Githuba. Inspiracją do zabawy był udostępniony przez Jakuba Mrugalskiego z Niebezpiecznika wynik jego zabawy z tym projektem, a we wszystkim wspomogła odrobina wolnego czasu przy okazji minionych świąt.

DeepFake podejście 1

Cała zabawa zajęła mi kilka godzin, ale zaznaczyć tutaj trzeba, że było to moje pierwsze zetknięcie się ze środowiskiem Colab, więc musiałem zacząć od nauki posługiwania się nim. W skrócie środowisko to daje możliwość korzystania z gotowych „notatników” zawierających fragmenty kodu, który wykonuje się w chmurze Googla i pozwala skorzystać z dostępnych w niej zasobów GPU. Trochę czasu zajęło mi też przygotowanie materiałów wejściowych ponieważ wymagane są filmy w rozdzielczości 256×256 oraz zdjęcia osób, których wizerunek chcemy sfałszować. Materiał wynikowy również wymaga obróbki, ponieważ domyślnie generowane jest nagranie w formacie 20kl/s i bez dźwięku. Trzeba zatem przekonwertować plik wideo i złożyć go w całość dokładając ścieżkę dźwiękową z filmu źródłowego.

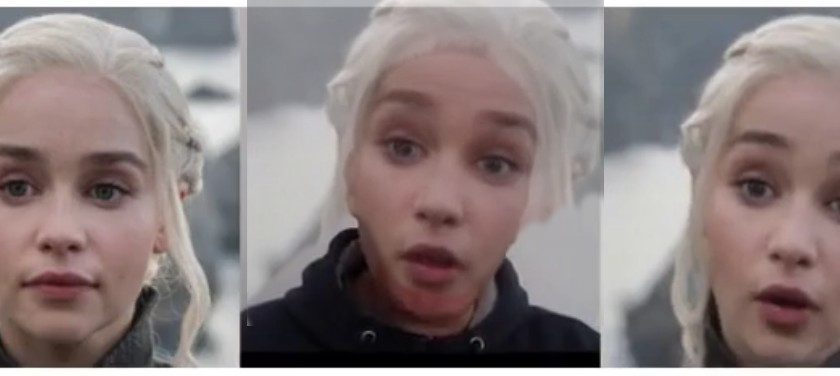

Wynik pierwszej próby widzicie poniżej. Obraz podzielony jest na 3 części. Pierwsze dwie to źródłowe zdjęcie dowolnej osoby oraz własne nagranie wideo. Trzecią stanowi natomiast wygenerowany przez algorytmy obraz wynikowy.

Ponieważ z natury nie jestem osobą zbyt ekspresyjną, wykonałem jeszcze jedną próbę, w której trochę bardziej przyłożyłem się do mimiki. Wybaczcie, ale to do celów edukacyjnych :). Jak widać, odwzorowanie jest całkiem zadowalające, chociaż np. zmarszczonego czoła na filmie wynikowym nie znajdziemy:

Czym nam zagraża DeepFake?

Scenariuszy wykorzystania tej technologii w złowrogich celach możemy sobie wyobrazić co najmniej kilka. Głównym zagrożeniem są oczywiście wszelkiego rodzaju manipulacje. DeepFake pozwoli np. utrzymywać przy życiu osoby zmarłe. Czy USA mogłoby skutecznie obwieścić światu sukces w postaci zlikwidowania Bin Ladena, gdyby Alkaida rozpowszechniała nagrania wideo z jego udziałem? A co gdyby ktoś zechciał wykorzystać wizerunek znanej osoby do celów politycznych? Zobaczmy taki przykład:

Nagranie zamieściłem w całości, wraz z moim filmikiem i zdjęciem użytym na wejściu, aby nikt nie wykorzystał go do manipulacji. Jeżeli komuś będzie jednak na tym zależało to posługując się opisanymi wyżej narzędziami bez problemu stworzy nagranie zawierające już tylko materiał wynikowy.

A co z głosem?

Pierwsze próby wygenerowania wypowiedzi konkretnej osoby na podstawie próbki jej głosu już się powiodły. Technologia RealTalk, ma w niedalekiej przyszłości pozwalać na generowanie takich wypowiedzi na podstawie tekstu dla dowolnych osób, których kilkusekundową próbką głosu będziemy dysponować. Na celowniku znajdą się zapewne znowu osoby publiczne, ponieważ ich nagrania i wizerunki są ogólnodostępne.

Jednak już w tej chwili osoby zajmujące się obróbką dźwięku byłyby zapewne w stanie mój głos na powyższych filmikach upodobnić do głosu prezydenta (z Emilią Clarke byłoby pewnie trudniej 🙂 ).

Kto będzie mógł z tego skorzystać?

Każdy. Już w tej chwili nie potrzeba jakiejkolwiek wiedzy specjalistycznej bowiem pojawiły się serwisy online, które za stosowną opłatą są w stanie uprościć cały proces. Zerknijcie chociażby na https://deepfakesweb.com. Godzina przetwarzania obrazu w tym serwisie kosztuje 2$. Można śmiało stwierdzić, że wkrótce technologia ta trafi pod strzechy.

Czy jesteśmy na to przygotowani?

Obawiam się, że nie. Spójżmy chociażby na szkody i zamieszanie, które w chwili obecnej potrafią wyrządzać wszelkie fake newsy. Społeczeństwo nie jest jeszcze niestety odpowiednio wyedukowane w zakresie rozpoznawania i filtrowania treści tego typu. Jednocześnie cyberpropaganda i dezinformacja stały się narzędziami wykorzystywanymi już nie tylko w walce politycznej, ale także w ramach działań wojennych (patrz przejęcie Krymu przez Rosję, wojna w Syrii).

Zostaw e-mail aby otrzymać powiadomienia o nowościach oraz dostęp do wszystkich bonusowych materiałów przygotowanych wyłącznie dla subskrybentów.